Apple retrasó la implementación de su tecnología para la detección y lucha contra la distribución de imágenes de explotación sexual de menores. Se tomará un tiempo para analizar las críticas sobre el programa, que planteaba analizar los dispositivos de las personas para alcanzar su meta, una medida que había defendido hace pocos días frente a las múltiples críticas.

“Hemos decidido tomarnos más tiempo durante los próximos meses para recopilar información y realizar mejoras antes de lanzar estas características de seguridad infantil”, aseguró un portavoz de Apple a 9to5Mac, palabras que más tarde se convertirían en parte de una declaración formal de la empresa en el apartado sobre la idea para detectar pedófilos.

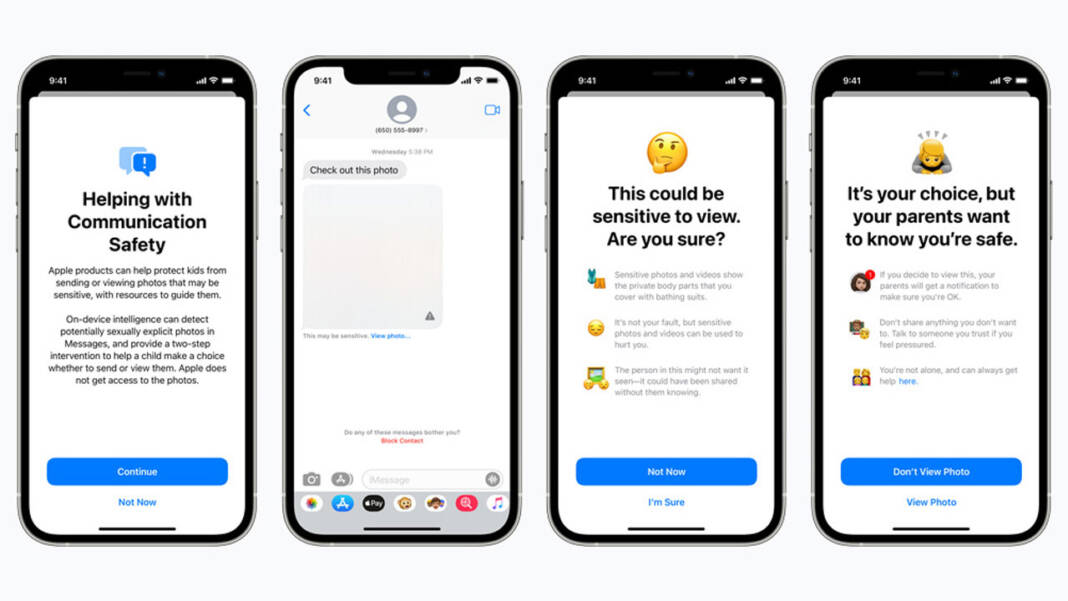

Apple planeaba una actualización de iOS 15, iPadOS 15 y macOS Monterey para introducir una nueva tecnología de detección de imágenes identificadas previamente como contenido sobre abuso de menores.

Leer más

En lugar de ocurrir en iCloud, el escaneo sucedía en los dispositivos de los usuarios, lo cual podría desencadenar una serie de violaciones a la privacidad.

“Anteriormente, anunciamos planes con nuevas funcionalidades destinadas a ayudar a proteger a los niños de los depredadores sexuales que usan herramientas de comunicación para reclutarlos y explotarlos, y para ayudar a limitar la propagación de material sobre abuso sexual infantil. Teniendo en cuenta los comentarios de los clientes, organizaciones legales, investigadores y otros, hemos decidido tomarnos más tiempo durante los próximos meses para recopilar información y realizar mejoras antes de lanzar estas medidas de seguridad infantil, de enorme importancia”, finalizó Apple.